|

||||||

|

|

Individueller Archivdaten-Ingest ohne Software-Entwicklung

Polymorphe Datenströme werden mit Adeptia ETL in eine für die Langzeitarchivierung taugliche Form transformiert und als Datenbank mit CSP CHRONOS archiviert. Adeptia ETL übernimmt dabei die Funktion «Ingest» im Sinne von ISO 14721 (Open Archival Information System — Reference Model).

Die Ingest-Funktion ist entscheidend für die Qualität der Archivierung. Sie muss deshalb stabil und fehlerfrei funktionieren, gut dokumentiert und leicht anpassbar sein.

Mit Adeptia ETL werden Daten-Workflows ohne Software-Entwicklung im Web-Browser erstellt, getestet und verwaltet — mit entsprechend tiefen Implementierungs- und Unterhaltskosten.

- Service-Baukasten — Aus über 70 lösungserprobten «Services» werden die benötigten Funktionen ausgewählt, im visuellen Prozess-Designer per «Drag-and-Drop» zu einem Workflow mit Ablauflogik zusammengesetzt und über «Wizards» konfiguriert.

- Wiedervendbarkeit — Bereits konfigurierte Services (Aktivitäten) befinden sich in einem Repository und können jederzeit in weiteren Workflows wiederverwendet werden.

- Einfache Testbarkeit — Während der Design-Phase kann ein Workflow im grafischen Debugger ausgeführt und jede einzelne Aktivität detailliert nachvollzogen werden.

- Rasche Anpassbarkeit — Workflows und Aktivitäten lassen sich rasch und ohne Kompilierung von Softwarecode anpassen. Änderungen wirken sich nicht auf laufende Instanzen des Workflows aus.

- Prozess-Dokumentation — Auf Knopfdruck wird eine detaillierte Dokumentation des Workflows als PDF-Dokument erstellt, das anschliessend in CHRONOS dem Datenbank-Archiv als Dokumentation hinzugefügt werden kann.

|

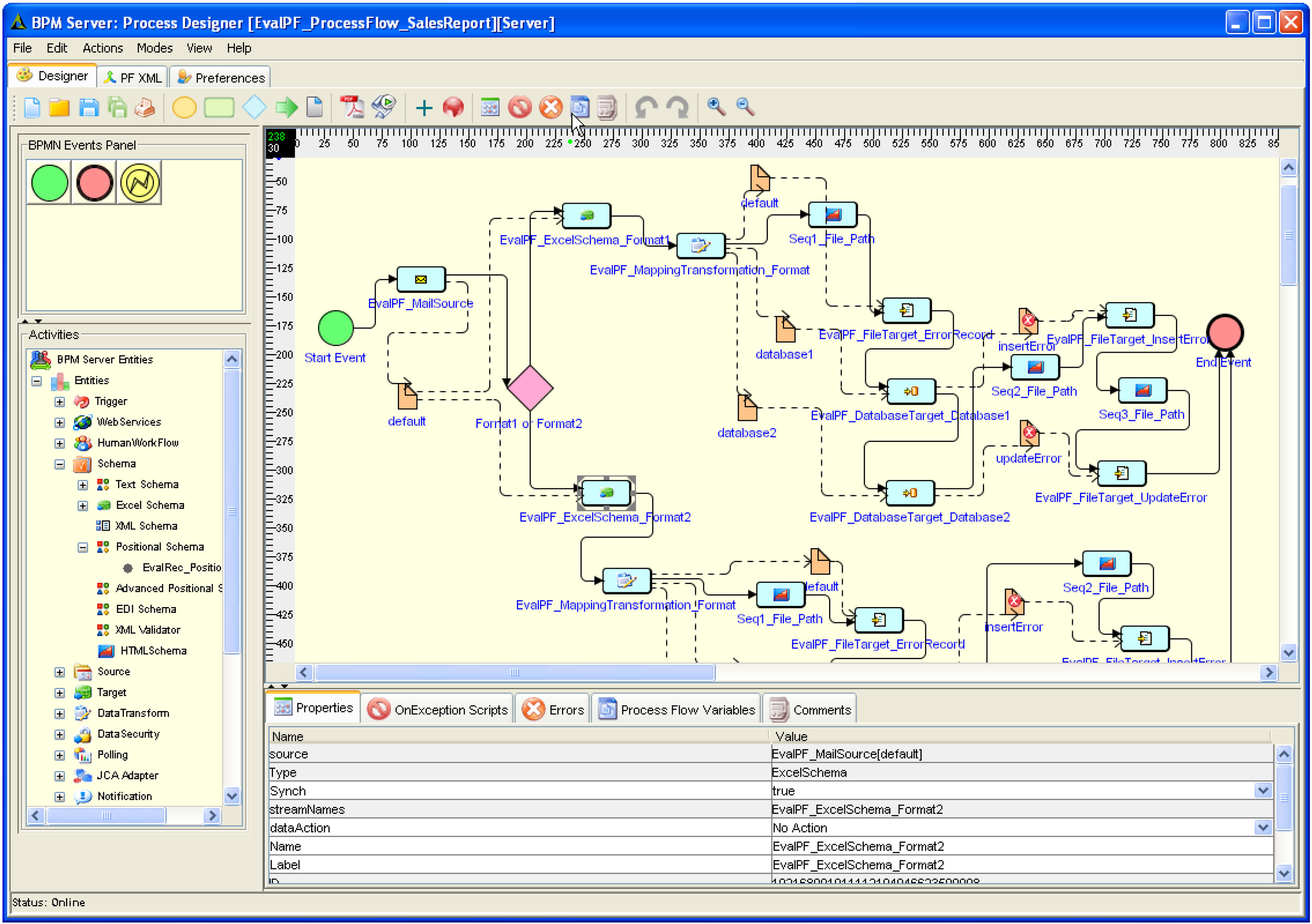

Prozess-Designer (Vergrössern: auf Bild klicken) |

Beispiel: «Advanced Positional Schema» |

Daten-Mapper |

Eine Transformation wird im visuellen Prozess-Designer als Workflow mit einer Ablauflogik und beliebig vielen einzelnen Aktivitäten definiert, die über den Web-Browser konfiguriert werden. Zum Beispiel:

- I/O-Services lesen und schreiben Daten über spezifische Protokolle, zum Beispiel Netzwerk-Dateisysteme, (S)FTP/S, HTTP/S, SOAP, SMTP/POP3, JDBC, JMS, WebDAV und JCA-Adapter.

- Format-Parser zerlegen Input-Dateien in individuelle Datenelemente, die anschliessend im Workflow verarbeitet werden, oder fügen umgekehrt Datenelemente zu einer Output-Datei zusammen. Unterstützt werden XML, ebXML, CSV, Excel, Flat Files, Fixed Length Positional Text Files, HTML, SQL DDL, EDIFACT, HL7, HIPAA, Accord AL3 und weitere.

- Daten-Transformationen konvertieren Daten zwischen polymorphen Schemata (z.B. XML auf ein Datenbank-Schema) und ermöglichen komplexe Berechnungen und Entscheidungen.

Der Kontrollfluss (durchgezogene Linien im Bild oben) legt die Reihenfolge der Aktivitäten fest und wird mit den Symbolen der standardisierten Business Process Model Notation BPMN dargestellt. Hier stehen die üblichen Konstrukte wie Forks, Joins, Loops, Subprozesse und Entscheidknoten zur Verfügung. Zusätzlich lassen sich Prozessvariablen definieren, auf die alle Aktivitäten im Workflow Zugriff haben.

Eine Datentransformation erscheint im Workflow als einzelne Aktivität und wird mit dem visuellen Daten-Mapper konfiguriert. Durch Multi-Schema-Mappings (1:N, N:1 und N:M) können heterogene Datenströme zusammengeführt bzw. aufgeteilt werden. Bei grossen Mengen uniformer Input-Daten («Bulk Data») ermöglichen Datentransformationen die automatische Parallelisierung.

Mit dem Daten-Mapper können nicht nur Datenelemente zugeordnet, sondern komplexe Berechnung mit Input-Daten durchgeführt und erst die Resultate dem Zielschema zugeordnet werden (siehe Bild oben).

- Manipulatoren filtern, aggregieren, berechnen und manipulieren Daten mit Hilfe eingebauter Mathematik-, String- und Logik-Funktionen oder externen Programmaufrufen.

- Modifikatoren ergänzen Input-Daten durch externe Daten, zum Beispiel aus einer Datenbank.

- Logische Weichen wie «If-Then-Else» oder «When-Case1-Case2-…» erlauben Fallunterscheidungen anhand des konkreten Inhaltes der Input-Daten zur Laufzeit der Transformation.

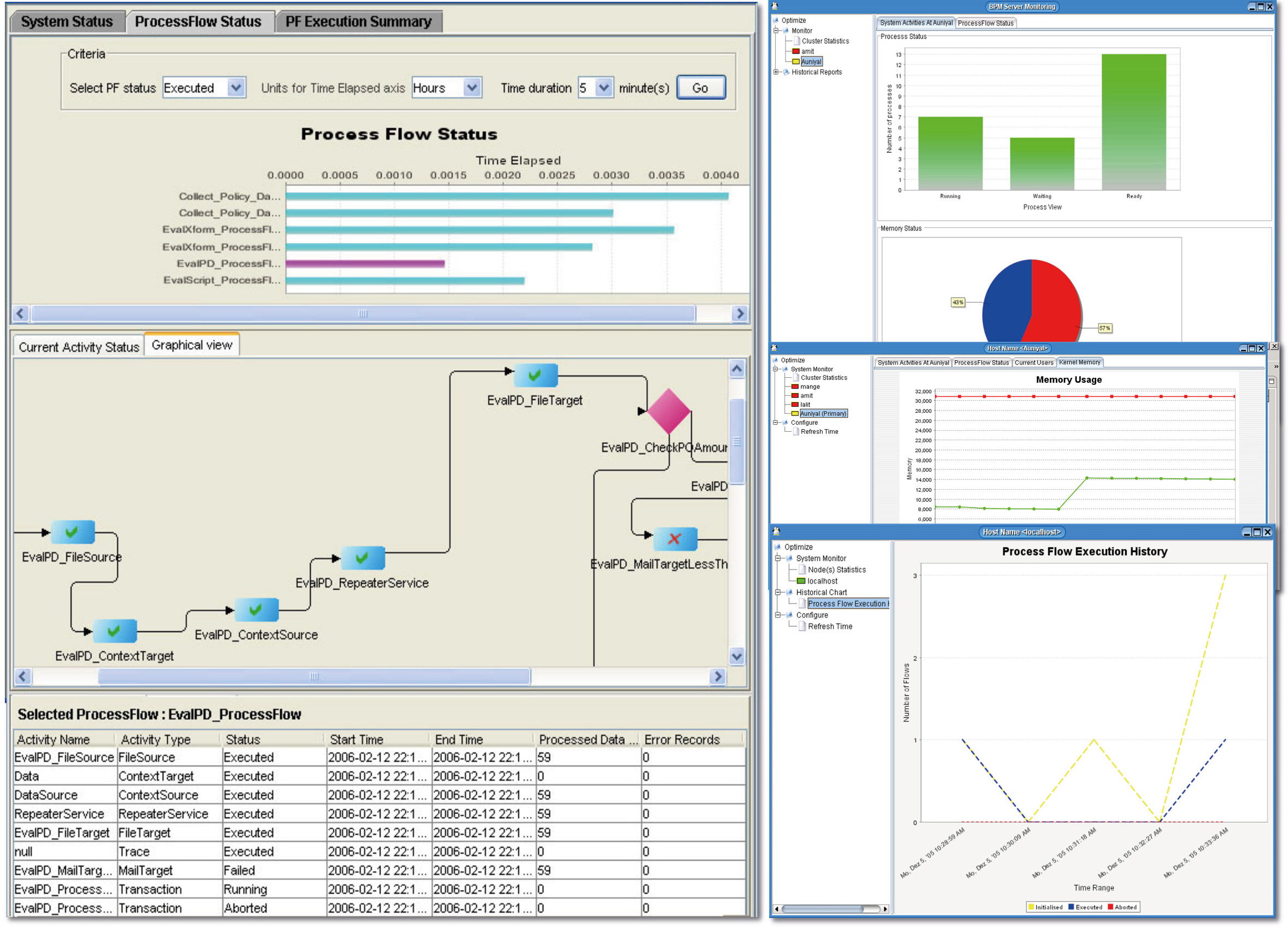

Beim automatisierten Archiv-Ingest polymorpher Datenströme mit Adeptia-Workflows behalten Sie dank zahlreicher Monitoring-Instrumente jederzeit den Überblick und die Kontrolle über laufende und pendente Prozesse, verarbeitete Datenmengen, Laufzeiten und Lastverteilungen.

- Der grafische Prozessmonitor zeigt Ihnen zu jedem laufenden Prozess in Echtzeit den Status der Ausführung jeder einzelnen Workflow-Aktivität.

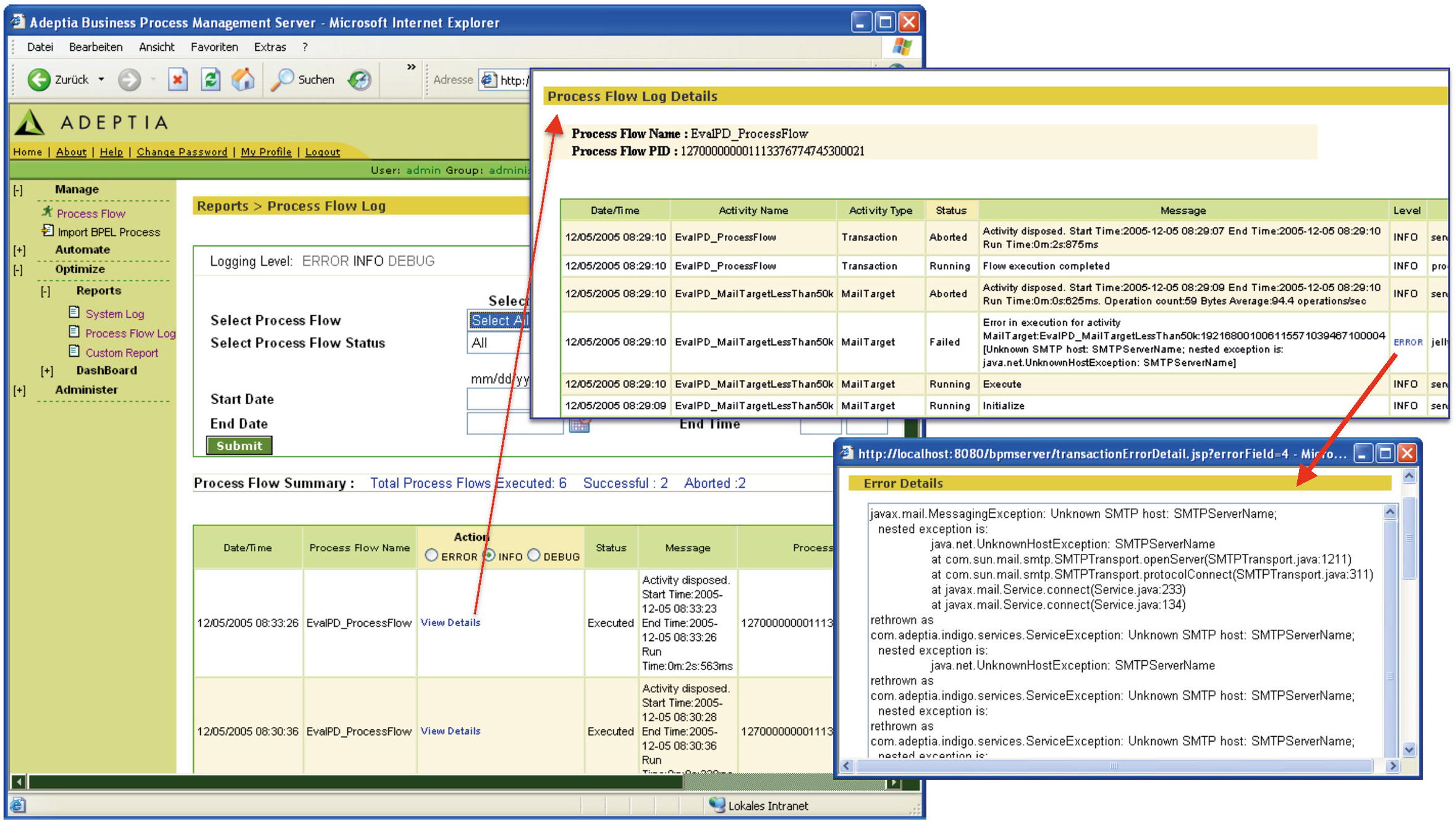

- Die Audit-Log-Datenbank zeichnet zu jedem Verarbeitungsschritt in jeder Aktivität jedes Prozesses detaillierte Informationen auf. Auch wenn Sie Tausende Prozesse mit geschäftskritischen Informationen verarbeiten und Nachvollziehbarkeit für Sie oberstes Gebot ist, können Sie beruhigt sein: Mit dem Auditlog können Sie jedes Detail belegen und nachweisen. Diese Audit-Daten können Sie zum Beispiel ebenfalls mit CHRONOS archivieren oder von Adeptia periodisch löschen lassen.

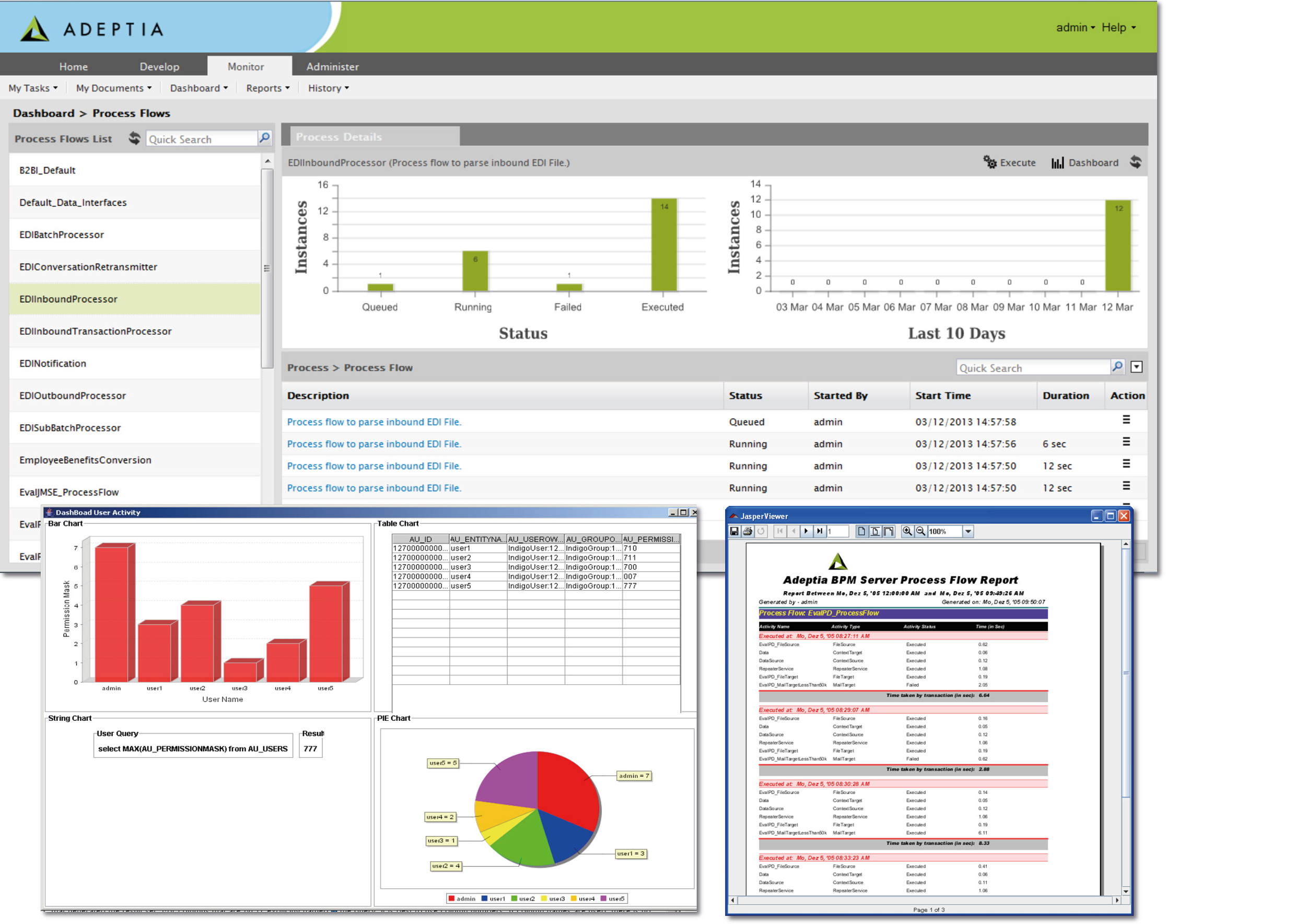

- Dashboards und Reports ermöglichen aggregierte Echtzeit-Sichten und analytische Auswertungen der von einem Prozess verarbeiteten Daten. So können Sie zum Beispiel Informationen, die aus bestimmten Gründen wichtig, kritisch oder verdächtig sind, in den archivierten Datenströmen detektieren, als Berichte im PDF-Format dokumentieren und sich per E-Mail zuschicken lassen. Für Berichte nutzt Adeptia ETL das OpenSource-Berichtswerkzeug JasperReports.

|

System-Monitore |

Audit-Log (Zum Vergrössern auf Bilder klicken.) |

Prozess-Reporting |